كان يوماً حزيناً للمطلعين على عالم التكنولوجيا، فقد وقع ما كانوا يخشون دوماً حدوثه، إنه واحد من أسوأ كوابيسهم يتحقق.

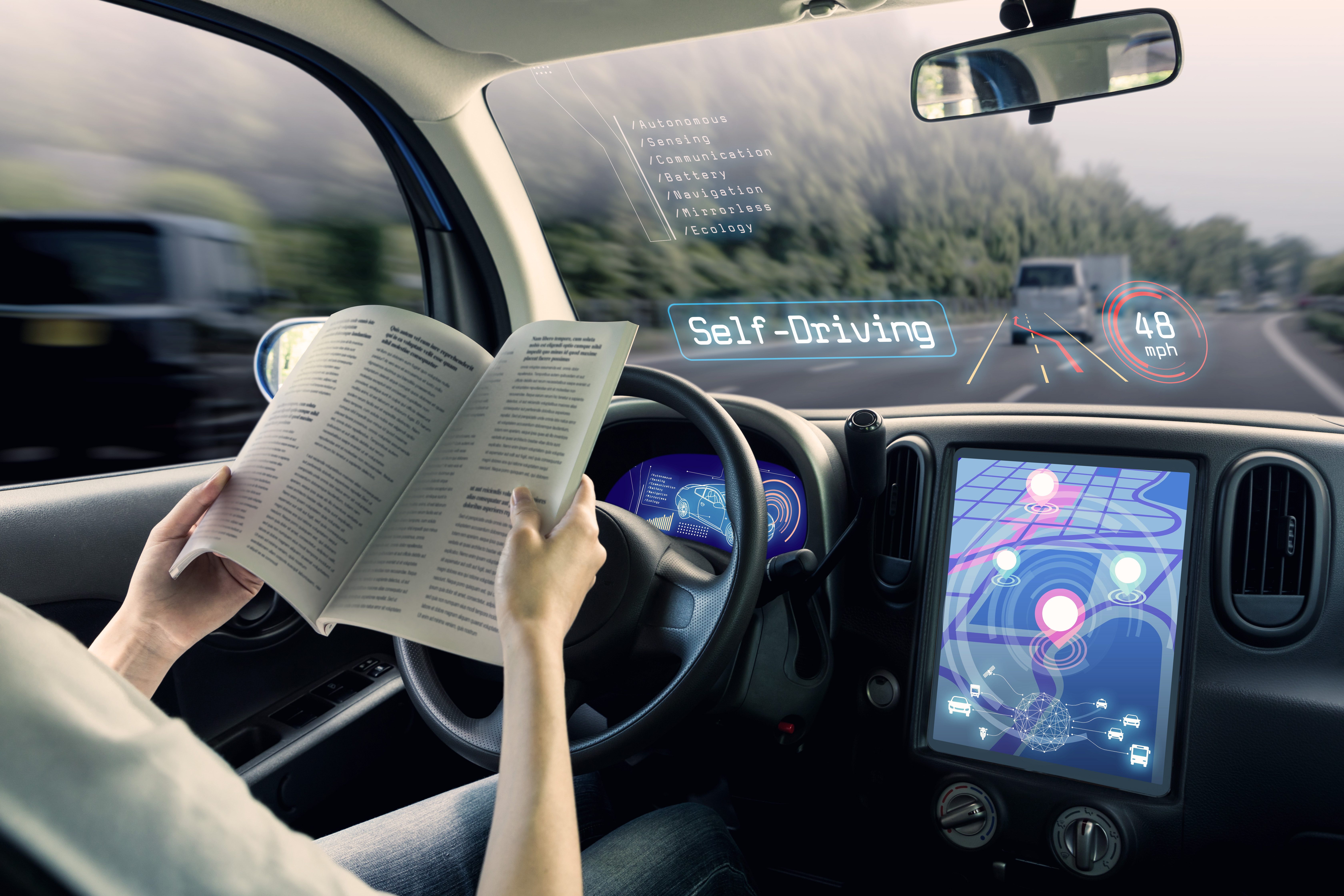

ففي مساء يوم 18 مارس/آذار عام 2018، لم يُسلِّط القمر بالكاد أي ضوءٍ على الشارع ذي الأربع حارات في مدينة تمبي بولاية أريزونا الأميركية، عندما ميَّزت سيَّارة أجرة معدلة خصيصاً تابعة لشركة أوبر من طراز Volvo XC90 شيئاً أمامها.

كانت تلك الشاحنة الخفيفة جزءاً من الحُمى المعاصرة المتمثلة في الاتجاه إلى تطوير مركباتٍ ذاتية القيادة، حسب وصف تقرير للكاتب البريطاني آندرو سميث، نشر في صحيفة The Guardian البريطانية.

إذ كانت العربة تُقاد على نحوٍ مستقل، بلا تدخُّلٍ من سائقها المُساعد، لمدة 19 دقيقة.

فقد حسبت أن أمامها شيئاً ساكناً

باستخدام مجموعة من أجهزة الاستشعار بتكنولوجيا الليدار (Lidar) الباعثة لموجات الضوء والرادار، حسبت الخوارزميات موجودة على متن المركبة، نظراً للسرعة الثابتة التي تسير بها السيَّارة وهي 43 ميلاً في الساعة (69 كيلومتراً في الساعة)، أنَّ الشيء المنظور كان على بُعد 6 ثوان، بفرض أنَّه ظلّ ساكناً.

لكن نادراً ما تبقى الأشياء على الطرق ساكنة، لذلك استعانت خوارزميات أخرى بقاعدة بياناتٍ من كياناتٍ ميكانيكية وبيولوجية يمكن تمييزها، باحثة عن شكلٍ مطابق يمكن من خلاله استنتاج السلوك المحتمل لهذا الشيء بعينه.

ثم ظنته سيارة أخرى، ولكن للأسف تبين خطأها ولكن بعد فوات الأوان

في البداية لم يسفر بحث الكمبيوتر عن شيء، وبعد مضيّ بضعة ثوانٍ، قرَّرت الماكينة أنَّ ما تتعامل معه كان سيارةً أخرى، متوقعةً أنَّ السيارة المقابلة ستمضي في طريقها ولا تتطلَّب اتخاذ فعلٍ تجاهها.

في الثانية الأخيرة فقط عُرِفَت ماهية الشيء بوضوح، كان امرأةً على درَّاجة هوائية، تتدلَّى أكياس تسوُّق على نحوٍ مربك من مقودها، مفترضةً لا ريب أنَّ سيارة الفولفو ستنعطِف من حولها كما يُتوقَّع من أي مركبةٍ عادية. وإذ يُمنَع الكمبيوتر من اتخاذ أي فعل تفادٍ من تلقاء نفسه، سلَّم الجهاز التحكُّم فجأةً لسيِّده البشري، لكنَّ سيِّده لم يكن يُعيره الانتباه الكافي.

ووقعت الكارثة وسقطت أولى ضحايا التكنولوجيا.. فهل فقد البشر السيطرة على الخوارزميات؟

صُدِمَت إيلاين هيرتزبرغ، التي كانت تبلغ من العمر 49 عاماً، وقُتلَت، تاركةً أفراد مجتمع التكنولوجيا مُحمَّلين بسؤالين مزعجين: هل كان يُمكِن تفادي وقوع هذه الكارثة الخوارزمية؟ ولأي حدٍّ نعتاد، أو يجدر بنا الاعتياد، على وقوع حوادثٍ كتلك؟

"فقدنا السيطرة بشكلٍ ما. عندما تصبُّ البرامج في أكوادٍ مبرمجة والأكواد في خوارزميات، ثم تبدأ الخوارزميات بخَلق خورازمياتٍ جديدة، تصير العملية أبعد فأبعد عن متناول الإرادة البشرية. تُطلَق البرمجيات في فضاءٍ من الأكواد لا يمكن لأحدٍ استيعابه كلياً".

إذا بدت تِلك الكلمات صادمة، فإنَّ هذا هو تماماً الغرض منها، لأسباب يتصدَّرها أنَّ قائلتها، إلين أولمان، بالإضافة لكونها مبرمجة بارزة منذ سبعينيات القرن الماضي، هي إحدى قلةٍ يكتبون كتابات مستبصرة عن عملية برمجة الأكواد. قليلٌ فقط ما لا تعرفه إلين عن البرامج في بيئتها الرقمية.

وتقول إلين: "يقول الناس: "حسناً، ماذا عن فيسبوك؟ إنَّهم يبتدعون ويستخدمون خوارزمياتٍ ويمكنهم تغييرها". لكنَّ الأمر لا يسير بهذه الطريقة. هُم فقط يُطلقون الأكواد، يبثُّونها، ثم تقوم تِلك بدورها بالتعلُّم ثم تغيّر وتشغِّل ذاتها. تتدخَّل شركة فيسبوك دورياً في عملية التشغيل تلك، لكنَّها لا تتحكَّم بأكوادها فعلياً. وبعض البرامج في حد ذاتها لا تعمل وحدها، بل إنَّها تُنادِي مكتباتٍ من الأكواد، وأنظمة تشغيلٍ متعمِّقة وهكذا".

أولاً دعنا نعرف ما هي الخوارزمية؟

قلَّما تجد مواضيع تُناقَش على نحوٍ متواصل أو حماسيّ كما يُتداول النقاش حول الخوارزميات. لكن ما هي الخوارزمية؟ في الواقع، تغيَّر استخدام الكلمة على نحوٍ مثير للاهتمام منذ ولادة الإنترنت، أو محرِّكات البحث خصيصاً، في منتصف التسعينيات.

في جوهرها، الخوارزمية شيء صغير: قاعدةٌ تُستخدم لتنفيذ معالجة جزءٍ من البيانات آلياً. إذا حدث (أ)، حينئذٍ افعل (ب)، وإلا افعل (ج). إنَّ هذا منطق "إذا/حينئذٍ/وإلا" (if/then/else) في علم الحوسَبة الكلاسيكي. إذا زعم مستخدمٌ أنَّه بلغ سنّ 18 عاماً، حينئذٍ اسمح له بدخول الموقع، وإلَّا اطبع رسالة بالآتي "عذراً، عليك أن تكون قد بلغت الثامنة عشرة لتدخل الموقع".

وفي صميمها، ليست برامج الكمبيوتر إلا رزماً من خوارزميات كتلك. وصفات للتعامل مع البيانات، على المستوى المجهريّ، لا شيء أبسط من ذلك. إذا بدت الكمبيوترات كما لو كانت تبتدع سحراً، فإنَّ هذا سببه سرعتها، لا ذكاؤها.

والآن أصبح لها معنى أكثر شؤماً؟

شهدت السنوات الأخيرة ظهور معنى أكثر غموضاً وشؤماً، إذ أصبحت كلمة "خوارزمية algorithm" تؤخَذ بمعنى أي نظامٍ برمجيّ ضخمٍ ومعقَّد لاتِّخاذ القرارات، بمعنى أي وسيلةٍ تقبَل مصفوفةً (جدولاً) من المُدخلات -أي البيانات- وتقيّمها بسرعة، اعتماداً على مجموعةٍ من المعايير أو "القواعد".

أحدث هذا المفهوم ثورةً في مجالات الطب، والعلوم، والنقل، والاتصالات، ما سهَّل استيعاب المنظور المثالي للحَوسبة، ذلك الذي كان مهيمناً لعدة أعوام. قدَّمت لنا الخوارزميات حياةً أفضل بطرقٍ شتَّى عديدة.

كان في عام 2016 فقط أن بدأ تتشكَّل رؤيةٌ أدق لواقعنا الخوارزمي الجديد. إذا كنَّا أميَل لمناقشة مفهوم الخوارزميات بمصطلحاتٍ أقرَب لحياكة الأساطير، باعتبارها كينوناتٍ مستقلة لها حيواتٌ خاصة بها، لأنَّ هكذا دُفِعنا على التفكير.

فلقد وعدنا فيسبوك وجوجل بأنها ستكون دقيقة وبالتالي بدأت تتحكم في مصائرنا

باعت الشركات الكبرى مثل فيسبوك وجوجل خوارزمياتها، ودافعت عنها في سياق وعدٍ بالموضوعية، بقدرتها على قياس مجموعةٍ من الجمل الشرطية بحس رياضيّ منفصل وفي غياب العاطفة المبهمة.

لا عجب إذن أنَّ آلية اتخاذ القرار الخوارزمية تلك امتدَّت لتشمل قرارات منح القروض/ الكفالة/ المساعدات/ مقاعد الدراسة/ مقابلات العمل وتقريباً أي شيء يتطلَّب حدوث اختيارٍ ما.

والآن البعض يعتبرها أسلحة الدمار الرقميّ الشامل

ولكن لم نعد نتقبَّل ترويج هذا النوع من الخوارزميات بالخنوع القديم ذاته.

كاثي أونيل، وهي طفلة معجزة في الرياضيَّات مسبقاً، تركت العمل في وول ستريت لتُدرِّس وتكتب في مدوَّنتها البديعة mathbabe، عرضت في كتابها الصادر عام 2016 بعنوان Weapons of Math Destruction أي ما يعني "أسلحة الدمار الرقميّ الشامل"، عرضت بشكلٍ لا ريب فيه أنَّه حقيقة مفادها أنه على النقيض من قيامها المزعوم بمحو عامل التحيُّز البشري، قد تفاقِم الخوارزميَّات منه وتقوِّيه.

فمن يصنعها؟ رجال ينتمون إلى هذه الفئات فقط في الأغلب

في النهاية، تُكتَب برامج الكمبيوتر بأيدي رجالٍ بيض وآسيويين ميسوري الحال، وحتماً فإنَّها ستعكس فرضيَّاتهم الشخصية (يمكنك إدخال عبارة "racist soap dispenser" بمعنى "جهاز موزِّع الصابون الآلي العنصري" في محرِّك البحث جوجل، لترى كيف قد ينكشف هذا في أشدّ مواقف الحياة الطبيعية اعتيادية، إذ اشتُهِر فيديو للجهاز وقد فشل في استشعار يدّ رجل أسود البشرة).

لا يتطلَّب انحياز الآلة تعمُّداً للأذى حتى يؤذي بالفعل، وبخلاف البشريّ، لا يمكننا بسهولة أن نطلب من حارس البوَّابة الخوارزمي أن يفسِّر لنا قراره.

وهناك دعوة إلى شفافية خوارزميّة

دَعَت كاثي لتطبيق "تدقيقٍ خوارزميّ" يُجرَى على أية أنظمةٍ ذات تأثير مباشر على العامة، وهي فكرةٌ معقولة ستُحاربها صناعة التكنولوجيا بضراوة، وهذا لأنَّ الخوازميات هي ما تبيعه تلك الشركات، وعليه يكون آخر ما قد يتطوَّعون بتقديمه هو الشفافية.

النبأ السار هنا هو أنَّ هذه المعركة قيد التحقُّق. النبأ المؤسف هو أنَّها تبدو الآن أمراً ظريفاً مقارنةً بما سيحدث بعدها، حسب وصف كاتب التقرير.

فلا أحد انتبه إلى أن الثورة الخوارزميَّة قد تكون خطِرة ومربكة

تركَّز قدرٌ مهول من الاهتمام تجاه الوعود البعيدة والمخاطر التي يمثِّلها الذكاء الاصطناعي، لدرجة أن أحداً لم يلاحظ أنَّنا نتحرك صوب مرحلةٍ جديدة من الثورة الخوارزميَّة من شأنها أن تكون خطِرة ومربكة بنفس القدر، وبالكاد وجَّهنا حيالها سؤالاً واحداً.

إنَّ الخوارزميات التي حذَّرت منها كاثي وغيرها مُبهمة العمل، وإن كان سلوكها يمكن التنبؤ به: إنَّها تفعَل ما جرت برمجتها لتفعله.

والبعض يتطلع إلى تشكيل جيش من المتطوعين لفحصها

من حيث المبدأ، يمكن لمبرمج بارع أن يفحصها ويعترض على أُسسها.

يحلم البعض منَّا بتجنيد جيشٍ من المواطنين يتولَّى هذه المهمة، على نحوٍ يشبه شبكة هواة الفلك ممَّن يدعمون خبراء المجال.

ويبدو حتمياً أن يُصاغ تشريعٍ لتمكين حراكٍ كهذا.

إنها غبية ولكن هناك حلم بأن يتوفر لديها ذكاء مماثل للبشر.. ولذا هي تحتاج للحدس

يمكننا وصف هذه الخوارزميات بأنَّها "غبية"، بمعنى أنَّها تُنفِّذ المهام المسندة إليها، وفقاً لمُعطيات أملاها عليها البشر. تعتمد جودة نتائج الكود على الفِكر والمهارة التي تمَّت بها عملية برمجتها. وفي المقابل من هذه الافتراضات، يوجد حلمٌ بعيد آخر بالذكاء الاصطناعي العام (AGI) الأشبه بالذكاء البشري.

يجدُر بالآلة الذكية حقاً أن يكون بمقدورها التشكيك في صحَّة حساباتها، مستندة في ذلك على شيءٍ يُشبه ما نسمِّيه بالحدس (ما قد نعتبره تراكماً مجمَّعاً من الخبرة والمعرفة).

ولكنها في الواقع أقل ذكاء من طفل صغير أو حتى مجرد حبار

لنرسم صورةً أوضح، أُشِيد بشركة DeepMind التابعة لجوجل عن استحقاقٍ لخلقها برنامجاً قادراً على إتقان ألعاب الفيديو القديمة، بادئاً لا بشيء سوى تعليماتٍ تُملي عليه الحصول على أعلى مجموع نقاطٍ ممكن.

تُسمَّى هذه التقنية "التعلُّم بالتعزيز Reinforcement Learning" وهي ناجحةٌ لأنَّه بمقدور الكمبيوتر أن يلعب ملايين المرات بسرعة حتى يتعلَّم ما يحرِز النقاط.

يسمِّي البعض هذه المقدرة بعينها "الذكاء الاصطناعي المحدود (أو الضعيف) Artificial Narrow Intelligence"، لكن هُنا تُستخدَم كلمة "الذكاء" بقدر ما يستخدم موقع فيسبوك كلمة "صديق"، كي توحِي بكونه شيئاً أكثر أمناً وأسهل فهماً من حقيقته.

لمَ؟ لأنَّ الآلة لا تعرف سياق ما تفعله ولا يمكنها فعل شيءٍ آخر. ولا يمكنها كذلك، وهو الأمر الحاسم، أن تنقل المعرفة تِلك من لعبةٍ لأخرى (ما يُسمَّى "انتقال التعلُّم")، ما يجعلها في العموم أقل ذكاءً من طفلٍ صغير، أو حتى حبَّار. بهذه العقلية يكون بمقدورنا أن نصِف رافعة نفطٍ أو حشرة المن بـ "الذكاء".

المشكلة أن المرحلة التي نوجد فيها حالياً هي الفاصلة بين الخوارزميات "الغبية" والذكاء الاصطناعي الحقيقي

تفوقنا الكمبيوترات بالفعل مهارةً في القيام بمهامٍ متخصِّصة بعينها، لكن اليوم الذي تُنافس فيه مقدرتنا العامة ما زال على الأرجح بعيداً، هذا إن حدث أبداً. قد لا يكون البشر هُم الأبرع في كثيرٍ من المهارات، لكنَّهم يحلِّون في المرتبة الثانية في فعل عددٍ مبهر من الأمور.

إليك المشكلة إذن. بين الخوارزميات الجامدة "الغبية" والذكاء الاصطناعي الحقيقي توجد أرض ملتبسة (بين-بين).

لقد دخلنا هذه المرحلة بالفعل دون أن نُلقِي بالاً وتقريباً بلا أي جدال، ناهيك عن الاتفاق فيما يخصُّ الأهداف، والأخلاقيات، والأمان، والممارسات الفُضلَى فيها. إذا كانت الخوارزميات من حولنا لم تصبح ذكية بعد، بمعنى أنَّها لا تقدر بشكلٍ مستقل أن تقول "العملية الحسابية تلك/المسار الناتِج ذاك لا يبدو منطقياً: دعني أُعيد الحِساب"، فإنَّها مع ذلك قد بدأت تتعلَّم من بيئتها.

والأخطر أنها حين تتعلم فلن نعرف ماذا يحدث لها.. إنها قد تصبح غريبة الأطوار

وبمجرَّد أن تبدأ الخوارزمية بالتعلُّم، لا نعُد نحن نعلم بأي درجةٍ من اليقين ما صارت إليه القواعِد والمُعطيات التي تعمل بها.

وعند هذه النقطة كذلك لا نعلم يقيناً كيف تتفاعل مع غيرها من الخوارزميات، أو مع العالم المادي، أو معنا نحن. حيث الخوارزميات الجامدة "الغبية" -برغم كونها معقَّدة، وغامضة، ومُعوَّدة بفعل مراقبةٍ تلازمها لحظةً بلحظة- يُمكن التنبؤ بسلوكها واستجوابها مجازاً، فإنَّ هذا النوع الجديد لا يخضع لأي من هذا.

وبعد وقتٍ من إطلاقها في الفضاء الرقمي الحر، لا نعرف بعد ذاك ماهية تلك الخوارزميات: تحمِل إمكانيةً بأن تصبح غريبة الأطوار. قد يُغرينا أن نطلق عليها اسم "فرانكن-خوارزميات"، مع أنَّ هذا سيناريو لم يكن ليخطر ببال الكاتبة ماري شيلي (مؤلفة فرانكنشتاين) نفسها.

وهناك تجربة سابقة في أسواق المال

هذه الخوارزميات ليست جديدة في حد ذاتها. يقول كاتب التقرير "لقد صادفتها أوَّل مرة منذ نحو الخمسة أعوام وأنا أجري بحثاً لأكتب مقالاً في صحيفة The Guardian البريطانية عن التداول عالي التردد (HFT) في البورصة التجارية".

ما وجدته آنذاك كان مدهشاً: نظامٌ رقمي معقَّد ومتشابك من صنع البشر، موزَّعٌ على أرففٍ من صناديق سوداء رابضةٍ كالنينجا في مزارع بياناتٍ (data farms) تبلغ قيمة المنشأة منها مليارات الدولارات.

ذاك ما أصبحت عليه البورصة الآن، حيث كانت هناك ساحات تداول فعلية، آلت كل نشاطات البورصة إلى خادمٍ (server) مركزي، فيه تقتات خوارزمياتٌ خفيفة مفترسة على أخرى مؤسسية ثقيلة، مقتادةً إياها لتبيع بسعرٍ أقل وتشتري بسعرٍ أعلى بإيهامها أنَّ تغيُّراً في حال السوق قد طرأ.

صِدام الأكواد تسبب في أزمة.. قصة الحرب الخفية بين الحيتان التكنولوجية التي كلفت العالم الكثير

سمَّى البشر المُداولين بترددٍ عالٍ (مع أنَّه لم يعُد هناك بشرٌ يتداولون في تلك البورصة بشكلٍ نشط الآن)، هؤلاء المشاركين الضِّخام البطيئين بـ "الحيتان"، وتعود ملكية معظم الحيتان لصناديقٍ مشتركة تقاعدية، أي هي ملكٌ للعامة.

وبالنسبة للشركات المُشتغلة بالتداول عالي التردد، كانت الحيتان الآن مصدرهم الأساسيّ للربح. إذن في جوهر الأمر، كانت هذه الخوارزميات تحاول دوماً أن تفوق إحداها الأخرى دهاءً، كانت تخوض معركةً خفية بسرعة الضوء، تتقدَّم بأمر شراء واحد ثم تُلغيه 10 آلاف مرة في الثانية أو تضرب النظام كله بعددٍ مهول من الأوامر يهزُّ السوق بأكملها، وكل هذا يحدث دون إشرافٍ أو تحكُّم من جانب البشر.

لم يكن لأحدٍ أن يتفاجأ إذن أنَّ هذا الوضع غير مستقر. عندما حدث "انهيارٌ فجائي flash crash" بالبورصة في عام 2010، وفيه سقطت البورصة سقوطاً حراً لمدة خمس دقائقٍ مدمِّرة، ثم صحَّحت مسارها لخمس دقائق أخرى تلتها، وكل هذا دون سببٍ واضح.

والنتيجة "انهيارات فجائية مصغَّرة" مرةً كل أسبوع

يقول كاتب التقرير: لقد سافرتُ إلى مدينة شيكاغو الأميركية لأقابل رجلاً يُدعَى إريك هونسيدر، وهو رجلٌ سمحت له براعته البرمجية الاستثنائية بالنظر إلى بيانات السوق المالية بتفصيلٍ أدق كثيراً ممَّا يراه مُنظِّموها، وبيَّن لي كيف أنَّه بحلول عام 2014، كانت تحدث "انهيارات فجائية مصغَّرة" مرةً كل أسبوع.

وحتى إن لم يستطع أن يُثبت قطعاً سبب حدوث ذلك، إلَّا أنَّه وطاقم موظَّفيه كانوا قد بدأوا يطلقون أسماءً على بعض الخوارزميات التي تعرَّضوا لها (أو كما يُطلَق عليها اختصاراً "algos" أو "خوَّات").

أجرى نيل جونسون، وهو عالم فيزياء متخصِّص في الأنظمة المعقَّدة لدى جامعة ميامي الأميركية، دراسةً عن تقلُّب سوق البورصة.

أخبرني جونسون: "إنَّه أمرٌ مدهش. ما أعنيه بذلك هو أن الناس تحدَّثوا أعواماً عن البيئة المعقدة والمتشابكة لأنظمة الكمبيوتر بحس من الغموض، بمصطلحاتٍ على غرار الفيروسات الدوديَّة وما غيرها. لكنَّه نظامٌ عاملٌ يمكن دراسته.

المشكلة الأكبر هي أنَّنا لا نعلم كيف يعمل هذا النظام أو ما قد يكون قد تولَّد عنه. ويبدو الموقف تجاهها يسير على نهج (البعيد عن العين…)".

إنه نظام جديد تسيطر عليه الآلة كلياً

الحدث الهام كان أن نُشِر بحث جونسون عن هذا الموضوع في مجلة نيتشر العلمية، ووصف فيه سوق البورصة باعتبارها "انتقالاً فجائياً على نطاق النظام بأكمله من مرحلةٍ يختلط فيها وجود البشر والآلة لمرحلة أخرى جديدة تسيطر عليها الآلة كلياً.

ويتَّسم هذا النظام بوقوع أحداث تُشبه ظواهر البجعة السوداء (أي تلك التي يُعدّ حدوثها غير اعتيادي البتة) على نحوٍ متكرِّر وتستمر لوقتٍ بالغ الصغر ثم تنحلّ".

والمشكلة أن بعض الشركات تسمح لخوارزمياتها بالتعلُّم

عقَّد من هذا السيناريو أنَّ بعض شركات التداول عالي التردد كانت تسمح لخوارزمياتها بالتعلُّم، ووفقاً للمؤرِّخ العلمي جورج دايسون.

أو كما قال: "أن تدع الخوارزمية، أو الصندوق الأسود الذي لم يعلموا ما بداخله، تجرِّب أشياءً مختلفة باستخدام مبالغ ضئيلة من المال، وإذا نجحت المحاولة، تقوِّي الخوارزمية من مجموعة القواعد التي تعمل بها، مضيفةً إياها على الدستور القديم، نعلم بالفعل أنَّ هذا حدث في تلك الشركات.

أي أنها تتطور مثلما يحدث مع الكائنات الحية

وعليه يصبح لديك حقيقة قواعد لا يعلمها أحد: الخوارزمية تخلق قواعدها الخاصة، وأنت تسمح لها بالتطوِّر على نحوٍ يشبه الكيفية التي طوَّرت بها الطبيعة الكائنات الحية".

بدأ مراقبو الصناعة غير المتخصِّصين مالياً بوضع فرضياتٍ تتوقَّع حدوث "انهيارٍ متناثر splash crash" عالمي وكارثي.

وفِي الوقت ذاته أصبح (ويبقى) المجال الأسرع نمواً في سوق المال مكوَّناً من أدواتٍ تتربَّح من تقلُّب السوق.

العلماء لم يستبعدوا حدوث "الفردية التكنولوجية" بل البعض يخشى من خوارزميات تقلد الطبيعة

في روايته الصادرة عام 2011 بعنوان "The Fear Index-مؤشر الخوف"، يتخيَّل الروائي الإنكليزي روبرت هاريس ظهور ذكاءٍ اصطناعي عام (AGI) -أو ظهور الفردية التكنولوجية singularity في حد ذاتها، إلهية القُدرة- من هذا المستنقع التكنولوجي بعينه.

ما أثار دهشة كاتب التقرير هو أنَّ أحداً من العلماء الذين تحدَّث معهم لم يستبعد بشكلٍ قاطع، حدوث سيناريو كهذا.

يقول الكاتب: "يمكن الإعراض عن القضية بأكملها باعتبارها مشكلة قاصرة على أروقة كبرى شركات المال، لولا وجود حقيقةٍ بسيطة. تنصُّ الحكمة التاريخية على أنَّ أوَّل من تبنَّى التكنولوجيا كانت صناعة الأفلام الإباحية، ثم تلاها الجميع".

لكن في القرن الـ21، حلَّت سوق المال محل الأفلام الإباحية؛ لذلك عندما رأيت ملامح لخوارزميات تُشبه تلك المستخدمة في التداول عالي التردُّد وقد تسبَّبت في مشاكل بمجالاتٍ أخرى، اتصلت بنيل جونسون مجدداً.

أخبرني جونسون: "أنت مصيبٌ تماماً في شكِّك ذاك"، هُناك نوعٌ جديد من الخوارزميلعيات يتحرَّك قاصداً عالمنا، نوعٌ "لديه القدرة على إعادة كتابة أجزاءٍ من كوده بنفسه"، وفي لحظةٍ ما سيصبح أشبه بـ"خوارزمية جينية" أي تقلِّد الطبيعة.

وهناك أدلة على ذلك في فيسبوك تحديداً

يعتقد جونسون أنَّه رأى أدلة على وجود ذلك النوع في حملات تقصِّي حقائق شنَّها بموقع فيسبوك (وأضاف: "لقد هوجمت حساباتي عليه 4 مرَّات"). إن صحَّ ذلك، فهذا يعني أن الخوارزميات تتنافس هناك أيضاً، وتتكيَّف، كما فعلت في البورصة.

ويقول: "في نهاية الأمر، ليس فيسبوك إلا خوارزمية كبيرة واحدة".

وأضاف: "أعتقد أنَّ تلك هي بالذات مشكلة فيسبوك. يمكنهم امتلاك خوارزميات بسيطة الهدف، منها التعرُّف على وجهي في صورةٍ على حساب شخصٍ آخر، والإتيان بمعلوماتي من حسابي الشخصي ثم إيصالنا بعضنا ببعض".

لكنَّ السؤال هنا هو أيُّ تأثيرٍ يكون لعمل مليارات من مثل هذه الخوارزميات على المستوى الكلي (الإجمالي)؟ لا يمكن توقُّع السلوك المكتسَب لهذه الخوارزميات على مستوى عددها ذاك استناداً إلى القواعد المجهرية التي تحكمها فحسب.

فهل يعلم فيسبوك ما يحدث لخوارزمياته؟ إنها تؤدي إلى استقطاب المجتمع

يقول جونسون: "لذلك، قد يزعم موقع فيسبوك أنَّه على درايةٍ كلية بما يحدث على المستوى الجزئي (المصغَّر)، وهم غالباً على حقٍ في مزعمهم ذاك. لكن ماذا يحدث على مستوى عددها أجمع؟ تلك هي المشكلة".

لتأكيد هذه النقطة، أصدر جونسون وفريقٌ من زملائه من جامعتي ميامي ونوتردام بحثاً، بعنوان "ظهور تجمهراتٍ فرعية متطرِّفة من المعلومات المشتركة والتحسُّن المحتمل أن تشهده الخوارزميات الرابطة المستقبلية"، تحاول تقديم إثباتٍ رياضيّ بأنَّ محاولات إيصال الناس بعضهم ببعض على الشبكات الاجتماعية تؤدي حتماً إلى استقطاب المجتمع ككل.

وعليهم أن يدرسوا آثارها مثلما يفعل علماء المناخ

يعتقد جونسون أنَّه يجب على فيسبوك وغيره من الشبكات الاجتماعية أن تضع (أو تُجبَر على وضع) نموذجٍ للأثر المتوقَّع أن تحمله خوارزمياتها بالطريقة نفسها التي يضع بها علماء المناخ نموذجاً متوقَّعاً للتغيُّر المناخي أو الأنماط الجوية.

تقول كاثي إنَّها اختارت استثناء التحدُّث عن هذا النوع من الخوارزميات المتكيِّفة من كتابها "Weapons of Math Destruction".

تشرح كاثي الأمر بأنَّه في بيئةٍ خوارزمية ملتفَّة التعقيد لا يمكن استيضاح شيءٍ فيها، يصبح توزيع المسؤولية على أجزاءٍ بعينها من الكود أمراً شديد الصعوبة. هذا يجعل تجاهلها أو صرف النظر عنها أسهل؛ لأنَّ آثارها الدقيقة يصعُب التعرُّف عليها. ثم تنصحني كاثي بأنَّه إذا ما أردت رؤية هذه الخوارزميات في بيئتها الطبيعية، فعليَّ سؤال ما الذي قد يكون عليه شكل الانهيار الفجائي إذا أصاب شركة أمازون.

كما أن هناك مشكلة في أمازون

تقول كاثي: "كنت أترقَّب ظهور هذه الخوارزميات أنا الأخرى. وكنت أفكر: (لم يصل مجال البيانات الضخمة لهذه المرحلة بعد). لكنَّ صديقاً يعمل بائعاً للكتب على موقع أمازون أخبرني في الآونة الأخيرة، كيف أنَّ وضع التسعير في الموقع أصبح جنونياً بالنسبة لناسٍ مثله.

بين الحين والآخر نرى تغريدة لأحدهم على موقع تويتر يقول فيها: (بإمكانك شراء صوفٍ فاخر على موقع أمازون مقابل 40 دولاراً). كلَّما سمعت أمراً كهذا أفكِّر: (إنَّ هذا مكافئ ظاهرة الانهيار الفجائي)".

تكثر القصص الدالَّة على وقوع أحداثٍ شاذَّة عن الطبيعي على موقع أمازون، معظمها يكون على هيئة سلسلةٍ من منشوراتٍ يكتبها بائعون مرتبكون، وبحث أكاديمي واحد على الأقل نُشِر في عام 2016، يزعم الآتي: "وردت أمثلةٌ على حالاتٍ تفاعل فيها برنامجان خوارزميان متنافسان لتسعير سلعةٍ ما أحدهما مع الآخر بشكلٍ غير متوقَّع، ونتج عنهما تسعيرات لم يمكن التنبؤ بها، بالإضافة إلى حالاتٍ صُمِّمت فيها الخوارزميات خصيصاً وعن عمدٍ لضمان تثبيت الأسعار".

من جديد، المشكلة هنا هو كيف تُوزَّع المسؤولية في بيئةٍ خوارزمية فوضوية، حيث لا ينطبق مبدأ السبب والنتيجة البسيط أو يكون مستحيل التتبُّع. وكما الأمر في عالم الماليَّة، حرية الإنكار جزءٌ لا يتجزَّأ من النظام.

هل تصل لنا المخاطر؟ حقيقة السيارة التويوتا التي تسارعت من تلقاء نفسها

عندما يطول الأمر ويصبح تهديدا لأمان البشر، تكتسب القضية أهميةٍ حقيقية.

فعندما خرج سائقٌ عن الطريق وقُتِل في سيَّارة من طراز Toyota Camry، بعدما بدا أنَّه قد زاد من سرعته لحدٍ جنوني دون سببٍ واضح، قضى خبراء من وكالة ناسا 6 أشهر يتفحَّصون ملايين السطور من الكود الذي كوَّن نظام تشغيل السيارة، دون العثور على دليلٍ يدعم ما اعتقدت عائلته أنَّه قد حدث بأن السيارة قد تسارعت من نفسها.

الشركة المصنِّعة للسيارة من جانبها، أنكرت بعزمٍ قاطع أن تكون السيَّارة زادت سرعتها من تلقاء نفسها.

المفاجأة أن خبراء اكتشفوا أن خوارزميات السيارة تعاركت فيما بينها

لكن، حدث فقط بعدما قضى اثنان من خبراء البرامج المضمَّنة (المُشغِّلة عادةً لأجهزةٍ حياتية يومية) 20 شهراً يتعمَّقون في كود السيارة، أن أمكنهم إثبات صحة قضية العائلة؛ إذ اكتشفا وجود كتلةٍ ملتوية ممَّا يلقِّبه المبرمجون بـ"كود السباغيتي أو الكود الملتوي"، حافلاً بخوارزميات تصادمت وتعاركت فيما بينها، ما ولَّد نتاجاً شاذاً لا يمكن توقُّعه.

تحتوي السيارات ذاتية القيادة الموضوعة تحت الاختبار الحالي على ما قد يبلغ 100 مليون سطرٍ من الكود، ونظراً إلى أنه لا مبرمج يمكنه استباق جميع الظروف الممكنة على طريقٍ حقيقي، على تلك السيارات أن تتعلَّم وتتلقَّى تحديثاتٍ مستمرة.

كيف نتفادى حدوث صدامٍ رقمي في وسطٍ كوديّ سائبٍ كهذا، خاصةً عندما قد تضطر الخوارزميَّات إلى التعامل مع هجمات المخترقين الإلكترونيين.

إذ تبين أنه لا يمكن التنبؤ بتصرفاتها

منذ 20 عاماً، توقَّع جورج دايسون حدوث أغلب ما نشهده اليوم، في كتابه الكلاسيكي "Darwin Among The Machines-داروين وسط الآلات".

يقول دايسون لكاتب التقرير، إنَّ المشكلة هي أنَّنا نبني أنظمةً تتعدَّى قدرتنا الفكرية على التحكُّم فيها. نحن نعتقد أنَّه إذا ما كان نظامٌ ما حتمياً (محدَّد النتائج، أي يتصرَّف وفقاً لقواعد ثابتة، وهذا تعريف الخوارزمية بادئ ذي بدء)، فإنَّه يمكن التنبُّؤ بتصرُّفه، وعليه فإنَّ ما يمكن التنبؤ به يمكن التحكُّم فيه. تبيَّن أن كلا الافتراضين خاطئ.

إنها كائناتٌ حية رقمية متعددة الخلايا

يقول دايسون: "إنَّها تسير من تلقاء نفسها، شيئاً فشيئاً وخطوةً بعد خطوة. إنَّ اليوم يسيطر على العالم كلياً كائناتٌ حية رقمية متعددة الخلايا، تُشبه تلك المرئية في علم الأحياء، حيث يكون لديك أجزاءٌ صغيرة من الكود تشتغل على هواتف الآيفون في حوزة الناس، وتعمل جماعياً كما لو كانت كائناً واحداً متعدد الخلايا".

وأضاف: "هُناك قانونٌ قديم يُدعَى قانون آشبي (Ashby's law) يقضي بأنَّ على نظام التحكم أن يكون بنفس درجة تعقيد النظام الخاضع لتحكّمه، ونحن نتَّجه لهذه المرحلة بسرعةٍ قصوى الآن، بدفعٍ مهول لتصنيع سيَّارات ذاتية القيادة حيث يتحتَّم على البرنامج الذي يشغِّلها أن يتضمَّن نموذجاً كاملاً لكل شيء، وبطبيعة الأمر يتحتَّم أننَّا لن نستوعب كل هذا.

لأنَّ النموذج الذي قد نستوعبه سيفعل شيئاً غبياً كأن يصطدم بسيَّارة إطفاء لأننا قد نسينا أن نُدخِل معطيات سيارة الإطفاء في النظام".

ويستحيل اختبار الخوارزميات بطريقة تستنفد جميع الاحتمالات

بخلاف أنظمتنا الميكانيكية الكهربية المعتادة، يستحيل كذلك اختبار هذه الخوارزميات على نحوٍ شامل يستنفد جميع الاحتمالات الممكنة. وحتى نملُك آلات فائقة الذكاء تقوم بتلك الاختبارات عنا، سنكون كالبهلوان السائر على الحبل.

يشكِّك دايسون فيما إن كنَّا سنرى يوماً سيارات ذاتية القيادة تتجوَّل بِحُرية في شوارع المدن.

ويفسِّر توبي والش، وهو أستاذٌ بالذكاء الاصطناعي في جامعة نيو ساوث ويلز الأسترالية كتب برنامجه الأول في سنّ الثالثة عشرة، وأدار شركة حوسبة حديثة العهد بحلول أواخر مراهقته، لمَ هذا الرأي صائب من المنظور التقني.

قال والش: "لا أحد يعلم كيف يكتب جزيئاً من الكود يتعرَّف على لافتة توقُّف إن صادفها. قضينا أعواماً نحاول أن نفعل شيئاً كهذا في مجال الذكاء الاصطناعي، وفشلنا! ما عطَّل حل هذه المشكلة هو غباؤنا؛ لأنَّنا لم نكن أذكياء كفاية لنتعلَّم كيف نقسِّم المشكلة لأجزاءٍ بسيطة كفاية بحيث يتوافق كلٌ منها مع أمرٍ يُعطَى للكمبيوتر (للآلة).

نحن ببساطة لا نعلم كيف نفعل هذا مع مشكلةٍ شديدة التعقيدة كالتعرُّف على لافتة التوقف أو ترجمة جملةٍ من اللغة الإنكليزية إلى الروسية، إنَّ هذا أمرٌ يفوق مقدرتنا. كل ما نعرفه هو كيف نكتب خوارزمية تعدُّدية الأغراض أكثر يمكنها التعلُّم، كيف تفعل ذلك بنفسها إذا ما أعطيناها أمثلةً كافية".

وبهذا يُسلَّط الضوء في اللحظة الراهنة على تعلُّم الآلة. نحن نعلم أنَّ إيلان، راكبة الدرَّاجة التي قتلتها سيَّارة أوبر ذاتية القيادة في ولاية أريزونا، ماتت لأنَّ الخوارزميَّات تردَّدت في التعرُّف على ماهيتها بشكلٍ صحيح. هل كان ذاك نتيجة برمجةٍ رديئة، أم غياب التدريب الخوارزميّ الكافي، أو رفض متغطرس عن الاعتراف بحدود التكنولوجيا التي نمتلكها؟ المشكلة الحقيقية هي أنَّنا قد لا نعرف أبداً أي منها السبب.

سيتوقف البشر عن كتابة الخوارزميَّات، وهذه الكائنات ستفعل بدلاً منهم

"وفي النهاية، سنتوقَّف نحن البشر عن كتابة الخوارزميَّات؛ هذا لأنَّ الآلات ستقدر على فعل ذلك أيضاً أفضل كثيراً من مقدرتنا"، حسبما يرى والش.

وفي ضوء هذا قد تكون هندسة البرامج مهنةً محتضرة، في طريقها للزوال. سيتولَّى القيام بها بدلاً منها آلات أفضل في فعلها بكثير ممَّا كنَّا".

ويرى والش أنَّ هذا يضفي أهمية أكثر، لا أقل، بأن يكون العامة على درايةٍ بالبرمجة؛ لأنَّه كلما أُقصينا عنها أكثر، بدت لنا سحراً يتخطَّى حدود سيطرتنا.

وعندما عُرِض لوالش تعريف الخوارزمية كما هو مكتوب مسبقاً في هذا المقال، وجده ناقصاً، معلقاً بالآتي: "يُمكنني القول إنَّ المشكلة في هذا التعريف هو أنَّ كلمة (خوارزمية) الآن تعني أي نظامٍ ضخمٍ معقَّد مبرمج لاتِّخاذ القرارات، ويُشار بها أيضاً إلى البيئة الأكبر التي تتضمَّنه، وهذا يجعل التنبؤ بها أصعب". هذه فكرةٌ مخيفة بالفعل.

وهذه يجب أن تكون الحدود الجديدة لعالم التكنولوجيا

يعتقد والش أنَّ الأخلاقيات هي الحدود الجديدة التي يجب فرضها في عالم التكنولوجيا، متنبئاً بحدوث "عصر ذهبي جديد للفلسفة"، وهو رأيٌ يوافقه فيه يوجين سبافورد، وهو خبيرٌ بالأمن السيبراني لدى جامعة بيردو.

ويقول سبافورد: "عندما يتوجَّب اتخاذ قراراتٍ، هُنا يأتي دور الأخلاقيات. ونحن نفضِّل امتلاك حسٍ بالتحكُّم أو السيطرة على الأمور يمكننا استجوابه أو توقيع اللوم عليه إن لزم، وهذا يصبح فعله شديد الصعوبة في التعامل مع خوارزمية. إنَّ ذاك هو تحديداً أحد الانتقادات الموجَّهة لهذه الأنظمة إلى الآن، أنَّها غير قادرةٍ على الرجوع للوراء وتحليل لمَ اتُّخذت هذه القرارات لا غيرها، وهذا لأنَّ عدد الخيارات الداخلية الممكنة مهولٌ لدرجةٍ تجعل كيفية وصولنا لنقطةٍ بعينها أمراً لا يمكننا أبداً إعادة مُحاكاته من جديد لنُثبت ارتكاب جرمٍ لا ريب فيه".

ويجب وقف محاولات البعض التنصل من المسؤولية

ومن جهةٍ أخرى، ينصُّ الرأي المقابل على أنَّه بمجرَّد ارتكاب برنامج واحد خطأً ما، يمكن إعادة كتابة أو تحديث شبكة البرامج بأكملها؛ حتى لا يقع الخطأ ذاك مرةً أخرى، وهذا بخلاف البشر الذين ستُدهش نزعتهم لتكرار الأخطاء آلات المستقبل الذكية لا ريب.

ومع ذلك، مع أنَّ التشغيل الآلي قد يكون هو الخيار الآمن على المدى الطويل، فإنَّه ستجب إعادة النظر في نظامنا الحالي المُستنِد إلى قانون الضرر (أو قانون المسؤولية التقصيرية)، ذلك الذي يتطلَّب إثباتاً بنيَّة أذى أو إهمال. لن تُلقى مسؤولية قانونية على كلبٍ إذا ما عضَّك، لكن صاحبه قد يتحمَّل المسؤولية تلك، لكن هذا فقط إن اعتُبِرَت تصرُّفات الكلب ممكنة التوقُّع.

في المقابل، بالبيئة الخوارزمية، ربما لم تكن عدة نتاجاتٍ غير متوقَّعة في إمكان البشر أن يتنبأوا بحدوثها، وهي سمةٌ يُحتمل أن تصبح ميثاق النذل، وفيه يمكن أن يكون التضليل المتعمَّد أسهل وأضمن ربحاً. تنفَّعت شركات الأدوية من ستار التعقيد لأعوامٍ مضت، لكن هذه المرة قد تكون العواقب أعظم ويكون عكس نتائجها أصعب في الوقت ذاته.

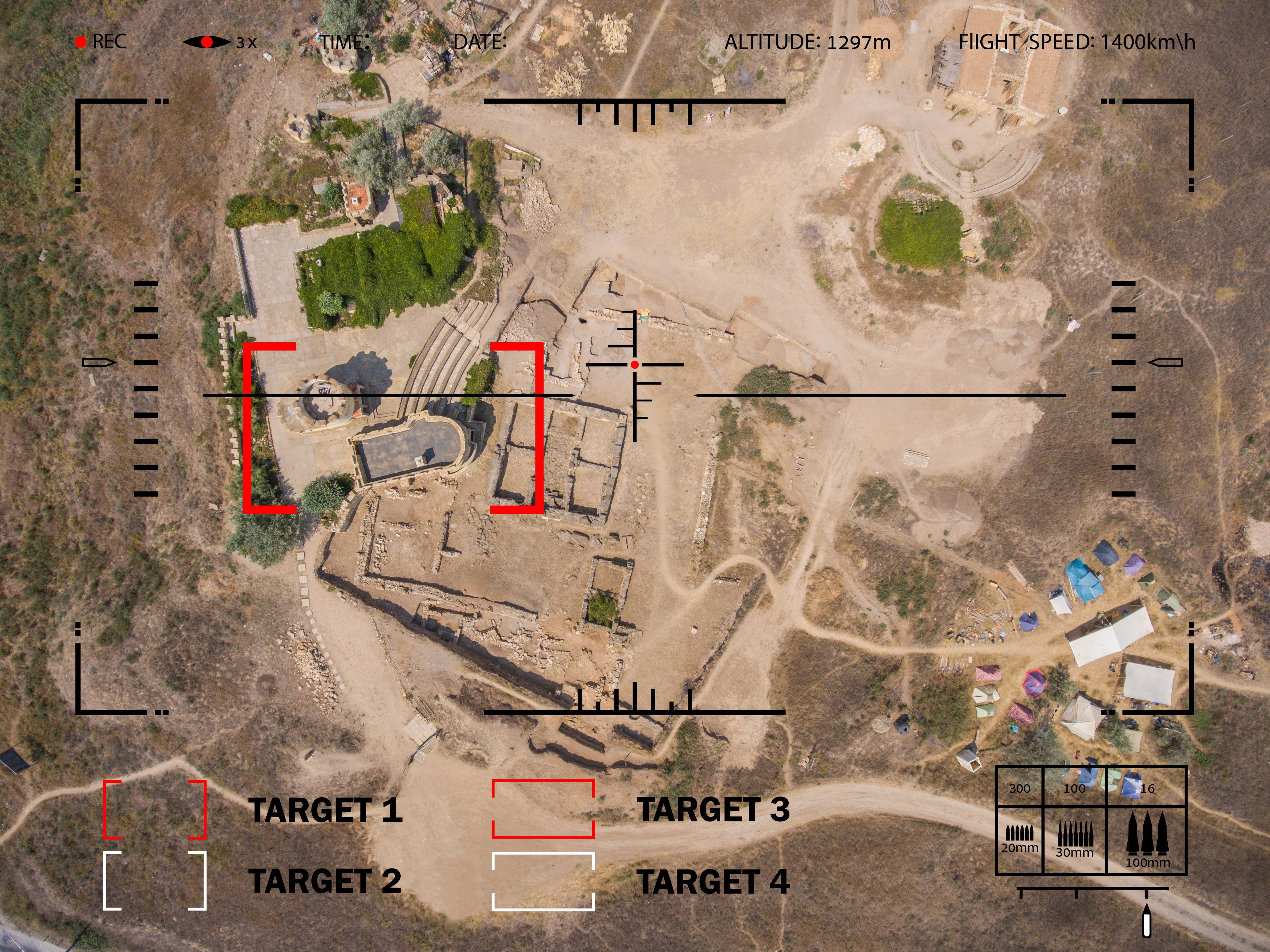

الأخطر ما يحدث في المجال العسكري

إذا كانت الجيوش لم تعُد تحرِّك نزعة الابتكارات كما كان يوماً، فإنَّها تظل أوَّل متبنٍّ للتكنولوجيا بالتبعية.

لا عجب إذاً في أنَّ المخاوف المُنهالة وسط العلماء والعاملين بالتكنولوجيا قد أتت مقترنةً باكتشافاتٍ، مفادها أنَّ الأسلحة ذاتية التشغيل تنساب متجهةً إلى أرض المعركة فيما قد يُنظَر إليه على أنَّه سباق أسلحةٍ خوارزميّ.

في اللحظة الراهنة يقوم روبوت قنَّاص على حراسة المنطقة منزوعة السلاح بين كوريا الشمالية والجنوبية، وفي حين تنكر شركة سامسونغ المصنِّعة له أنَّ الآلة قادرة على التشغيل الذاتي، فإنَّ مزعمها ذاك لاقي شكوكاً على نطاقٍ واسع.

تزعم روسيا، والصين، والولايات المتحدة جميعاً أنَّها قيد مراحل مختلفة من تطوير أسرابٍ من الطائرات بلا طيَّار المسلَّحة، في حين تخطِّط الأخيرة لتطوير صواريخ قادرة على الحوم حول أرض المعركة أياماً، في وضع المراقبة، قبل أن تختار أهدافها من تلقاء نفسها.

استقالة جماعية في جوجل بسبب البنتاغون

استقالت مجموعة من موظَّفي شركة جوجل، وأعرب الآلاف عن تساؤلاتٍ على خلفية إمداد شركة التكنولوجيا العملاقة البنتاغون الأميركي (وزارة الدفاع الأميركية) ببرنامج رقمي يشتغل بتقنية تعلُّم الآلة، ليوظَّف في برنامج البنتاغون المسمَّى "الحرب الخوارزمية" المُدار ضمن مشروع ميفن Project Maven، وهي تساؤلات ردَّت عليها إدارة جوجل في النهاية، موافقةً على ألَّا تجدِّد عقد مشروع ميفن، وأن تنشر مدونة للقواعد الأخلاقية تحكُم كيفَ تُستخدَم خوارزمياتها. وحتى وقت كتابة هذا المقال، قاوم منافسو جوجل مثل شركات أمازون ومايكروسوفت أن يحذوا حذوها.

والشركة قالت إن البرنامج سيُنقِذ حياة الأبرياء

وكما فعلت غيرها من شركات التكنولوجيا، كانت جوجل قد زعمت أنَّ برنامجها المقدَّم لمشروع ميفن لا غبار عليه أخلاقياً، وأنَّ البرنامج سيساعد على اختيار الأهداف بشكلٍ أكثر فاعلية، وبذلك سيُنقِذ حيوات الأبرياء. السؤال المطروح هنا هو: كيف لمديري التكنولوجيا أن يفترضوا معرفتهم بما ستفعله خوارزمياتهم أو كيف توجَّه على أرض المعركة، وخاصةً نظراً إلى أنَّه من الموكَّد أن جميع أطراف القتال بعد ذاك ستطوِّر أنظمة مضادة للخوارزميات المتغيِّرة تُصمَّم لإرباك أسلحة العدو؟

وكما كان الأمر في البورصة، فإنَّ غياب القدرة على التنبؤ بها يُحتمل أن يكون أمراً قيّماً كما يمكنه أن تكون عائقاً؛ إذ تمنح الأسلحة فرصةً أفضل لمقاومة محاولات تخريبها أو إبطالها. وفي هذا وبطرقٍ أخرى غيرها، نُخاطر بقلب آلاتنا كجرابٍ مقلوب، ونلفُّ عالمنا المادي اليومي بكود السباغيتي.

والواقع أن البنتاغون لديه بيانات أكبر من أي إمكانية لتحليلها

شاركت لوسي زوكمان، من جامعة لانكستر بالمملكة المتحدة، في كتابة خطابٍ مفتوح وجَّهه باحثون بمجال التكنولوجيا لشركة جوجل، طالبين منها التمهُّل والتفكير ملياً في تسرُّعها لعسكرة ابتكاراتها.

تقول لوسي إنَّه يسهُل فهم الدافع المحرِّك لشركات التكنولوجيا؛ إذ لطالما كانت العقود العسكرية مربحة للغاية، لكن البنتاغون من جانبه يمتلك شبكةً شاسعة من أجهزة الاستشعار وأنظمة المراقبة فاقت أي قدرةٍ على استغلال دفق المعلومات المُجمَّعة بهذه الطريقة.

وقالت لوسي: "إنَّهم غارقون في البيانات؛ هذا لأنَّ لديهم طرقاً جديدة لجمعها وتخزينها، لكن لا يمكنهم معالجتها. وبذلك تكون تلك البيانات غير ذات فائدة، إلَّا إن حدث إعجازٌ ما. وأعتقد أنَّ تجنيدهم شركات البيانات الضخمة هو نوعٌ من التفكير الإعجازي على طريقة: (هاك بعض التكنولوجيا السحرية التي ستُخرِج المعنى من كل هذه البيانات)".

ونتائج هجمات الطائرات من دون طيار في باكستان جاءت مفزعة

كذلك، تعرض لوسي إحصائياتٍ تُلقي ضوءاً مفزعاً على مشروع ميفن.

فوفقاً لتحليلٍ أُجرِي على هجماتٍ نفذتها طائرات بلا طيار في باكستان بين عامي 2003 و2013، كان أقل من 2% من الأشخاص الذين قتلتهم هذه الطائرات أفراداً أمكن إثبات كونهم أهدافاً "ذات قيمة عليا" تمثِّل خطراً واضحاً على أمن الولايات المتحدة.

وفي المنطقة ذاتها، تأكَّد أنَّ 20% من المقتولين كانوا غير مقاتلين -أي مدنيين- وهذا يترك بنسبة تفوق 75% مجهولاً وضعهم. وحتى إن كانت هذه الأرقام تحيد عن الصحَّة بفارق الضعف -أو حتى 3 أو 4 أضعاف- فإنَّ من شأنِها أن تدفع أي شخصٍ عقلاني للتوقُّف والتأمل.

والتكنولوجيا تصعب مساءلتها

وقالت: "إذاً يصبح بين أيدينا تكنولوجيا خام وليدة -لم تُدرَّب كفاية- للتعرُّف على الأهداف، وما يطرحه مشروع ميفن هو أن يُحوَّل ذلك للتشغيل الأوتوماتيكي. وعندها تُصبح مُساءلته أصعب ممَّا كانت بالفعل ويصير أعصى على الاستجواب. إنَّها فكرةٌ سيئة بحق".

تذكِّرنا ليلي إيراني من جامعة كاليفورنيا بمدينة سان دييغو، وهي زميلة لوسي زوكمان، بأنَّ المعلومات تسري في الأنظمة الخوارزمية بسرعة الضوء، بشكلٍ يخلو من أي إشرافٍ بشري.

وترى ليلي أنَّ المناقشات التقنية تُستخدم عادةً بمثابة ستارٍ مُعتِم لتجنُّب المسؤولية.

فالخوارزميات تحميها البيروقراطية، وفي الحروب الجديدة سيكون هناك قتل بلا مسؤولية

وقالت: "عندما نتحدث عن الخورازميات، أحياناً يكون ما نتحدث عنه فعلاً هو البيروقراطية.

تُقدَّم الاختيارات التي يتَّخذها مصمِّمو الخوارزميات وخبراء السياسة باعتبارها هدفاً أولياً، في حين كان يمكن بالماضي أن يُضطَر أحد إلى تحمُّل مسؤوليتها. تقول شركات التكنولوجيا إنَّها تحسِّن دقة مشروع ميفن فحسب -بمعنى أن يُقتَل الأشخاص المُرادون وليس غيرهم- وبقولهم ذلك، لا يتصدَّى أحد للفرضية السياسية بأنَّ هؤلاء الأشخاص على الجانب الآخر من العالم مُباح قتلهم، وأنَّه يصبح بيد الجيش الأميركي أن يعرِّف ماهية الاشتباه الذي يستدعي القتل.

إذاً، تُستخدم الأسئلة التكنولوجية لسدّ الطريق أمام أسئلةٍ هي في حقيقتها سياسية. إنَّ اختيار استخدام الخوارزميَّات لتشغيل اتخاذ قراراتٍ بعينها هو أمرٌ سياسي كذلك".

بقدر ما تُعَد بعيدةً كل البعد عن الكمال في حد ذاتها، فإنَّ الأعراف القانونية للحروب المعاصرة تنصُّ على أنَّ البشر مسؤولون عن القرارات المُتَّخذة في الحرب. وبذلك، على أقل تقدير، فإنَّ الحروب الخوارزمية تعكِّر وضوح هذا الموقف بطرقٍ قد نندم عليها فيما بعد. وقد وُضعت هذه القضية على جدول أعمال مجموعة من الخبراء الحكوميين في مؤتمر الأمم المتحدة لحظر أو تقييد استعمال أسلحة تقليدية معينة (CCW)، الذي عُقِد بجنيف في أغسطس/آب 2018.

بعد كل هذا هل هناك حل؟

توجَد حلولٌ بالفعل أو يمكن إيجاد حلولٍ لمعظم المشاكل الموصوفة في هذا المقال، حسب الكاتب.

لكنَّها ليست ممكنة دون أن تُدفَع شركات التكنولوجيا الكبرى كي تضع صحَّة المجتمع على قدم المساواة مع أغراضها الأساسية.

الأمر الأخطر والأهم هنا هو أن يسود الاعتقاد بأنَّ أساليب البرمجة الحالية لم تعُد تفي بالغرض؛ نظراً إلى ما نشهده الآن من ضخامة، وتعقيد، واعتمادية المتبادلة بين الأنظمة الخوارزمية التي يزداد اعتمادنا عليها يوماً بعد يوم.

هناك حل يستخدم في الطيران

ينصُّ أحد الحلول، الذي طبَّقته إدارة الطيران الفيدرالية الأميركية فيما يخصُّ الطيران التجاري، على الاحتفاظ بسجلٍ وتقييم المحتوى الذي تُنتجه كل البرامج المُستخدَمة والتحديثات المترتبة على مستوى تفصيلي لدرجةٍ تجعل كل التفاعلات الخوارزمية مفهومة بشكلٍ جيد مسبقاً.

لكنَّ هذا حلٌّ يفتقر إلى العملية إذا ما طُبِّق على نطاقٍ واسع أو في نظامٍ أضخم.

وتتبع أقسامٌ من صناعة الطيران نهجاً جديداً نسبياً يُدعَى البرمجة المُستندة إلى نموذج (Model-based programming)، وفيه تقوم الآلات بأغلب مهمَّة كتابة الأكواد ويكون بمقدورها أن تختبر صحَّة وسلامة الكود خطوةً بخطوة.

ولكنه يؤدي إلى مزيد من الإقصاء للبشر

ومع ذلك، قد لا تكون البرمجة المُستندة إلى نموذج، الدواءَ الشافي الشامل الذي يأمل البعض العثور عليه.

إنَّ هذه المقاربة لا تُقصي البشر أبعد فأبعد عن عملية البرمجة فحسب؛ بل إنَّ جونسون، عالم الفيزياء، أجرى دراسةً تابعة لوزارة الدفاع اكتشفت وجود "سلوكيَّات شاذَّة لم يمكن استنباط مصدرها من الكود نفسه"، حتى في الأنظمة الضخمة المُعقَّدة المبنيَّة باستخدام هذا التكنيك.

تُحوَّل الطاقات الآن تجاه إيجاد طرقٍ لتتبُّع السلوك الخوارزمي غير المتوقَّع وصولاً إلى سطورٍ بعينها من الكود سبَّبت حدوثه.

لا يعلم أحدٌ ما إن كان سيتمّ العثور على حل (أو حلول)، لكن يُستبعَد أن ينجح أي من الحلول المُرتقبة طالما كانت تُصمَّم الخوارزميات العدوانية لتتصادم و/أو تتكيَّف.

والحل في أن يتحمل هؤلاء المسؤولية

وفي حين ننتظر أن تُقدِّم لنا التكنولوجيا حلاً لمشكلة التشابك الخوارزمي المتفاقم، هناك احتياطاتٌ يمكن اتِّخاذها. بامتعاضٍ يقترح بول ويلموت، وهو خبيرٌ بريطانيّ بالتحليل الكمِّي ومجاهرٌ بنقده التداول عالي التردُّد في البورصة، أن "نتعلَّم إطلاق النار، وصناعة المربى، والحياكة".

الحل الأكثر عملية الذي يقترحه سبافورد، خبير الأمن البرمجي، هو أن تُحمَّل كل شركة مسؤولية الأفعال التي ترتكبها برامجها، سواء أمكن التعرُّف على سطورٍ بعينها من الكود الفاسد -أو إيجاد دليلٍ على إهمال الشركة فيما يخصُّه- أم لا.

ويشير سبافور إلى أنَّ جمعية آلات الحوسبة (ACM) الموقَّرة حدَّثت مدوَّنة القواعد الأخلاقية التابعة لها على نحوٍ يتماشي مع قَسَم أبقراط في الطب؛ إذ تُرشِد ممتهني البرمجة بألَّا يُحدِثوا ضرراً وأن يفكِّروا في الواقع الأشمل لما يصنعونه.

وما بات من قبلُ قضية أقرب إلى الخيال العلمي تحوَّل اليوم إلى مثار جدل بالانتخابات

ومن جانبه، يعتبر جونسون أنَّ الضيق الخوارزمي الذي نشعر نحن به الآن وهو تصوُّريٌّ ولو بشكلٍ جزئي، هو انزعاجٌ متزايد نشعر به في حيِّزٍ جديد من التجربة البشرية. يضحك جونسون مشيراً إلى أنَّه عندما تحدَّثت معه في هذه الأمور منذ بضع سنواتٍ لا أكثر، كانت أسئلتي أشبه بمخاوف متخصَّصة وقاصرة على قلةٍ من الناس من المتعمِّقين بشؤون البورصة وأدق تفاصيلها.

وقال: "والآن، انظر إلامَ انتهينا، إنَّها تؤثر حتى في الانتخابات. ماذا يحدث هنا؟ أعتقد أنَّ المسألة العلمية في عمق هذه التكنولوجيا هو أنَّ مهندسي البرامج تدرَّبوا على أن يكتبوا برمجياتٍ الغرضُ منها الوصول للحلّ الأمثل (أو ما يُسمَّى بالأمثلية Optimization)، وهذا لسببٍ وجيه هو أنَّك دائماً ما تحسِّن حساباتك استناداً إلى عوامل مثل توزيع الحمولة على متن طائرة، أو السرعة التي يصبح عندها استهلاك الوقوع أكثر فاعلية: في الظروف العادية، ممكنة التوقُّع، تكون الأمثلية أو نشدان الكمال هذا أمراً عقلانياً.

ويبدو أن الوضع معقد للغاية فلا حل قريباً، فهل علينا ابتكار علم جديد؟

لكنَّ العكس هو الأصح في الظروف غير الاعتيادية، وعلينا طرح السؤال الآتي: (ما هو أسوأ شيءٍ قد يحدث بهذه الخوارزمية إذا بدأت بالتعامل مع خوارزميات غيرها؟)، المشكلة هي أنَّنا لا نملك حتى مصطلحاً يصف هذا المفهوم، ما بالك بعلمٍ لدراسته!".

يسكُت جونسون لحظة، محاولاً إعمال عقله لإحاطة المشكلة.

ثم يقول: "الفكرة هنا هي أنَّ الأمثلية، أو الوصول للحلّ الأمثل، تتعلَّق بإيجاد قيمةٍ قصوى أو دُنيا لمسألةٍ ما، وهي واحدٌ في نظر الكمبيوتر. إذاً ماذا يكون النقيض من الأمثلية، أي كيف نجد الحل الأقل مثالية، وكيف نعرِّف شيئاً كهذا ونقيسه؟ إنَّ السؤال الواجب طرحه، والذي لا نطرحه أبداً حقيقةً، هو الآتي: (ما هو السلوك الأشد تطرُّفاً المُحتمل وروده من نظامٍ كُنت أظن أنِّي أحسِّنه حدَّ الكمال؟)".

ينتهي صمتٌ وجيزٌ آخر بجونسون وهو يقول شيئاً تلمح في صوته أنَّه مفاجأ به هو الآخر.

يقول: "إذاً، نحن في الأساس بحاجةٍ لابتداع علمٍ جديد".