حذّر التقرير السنوي الدولي لسلامة الذكاء الاصطناعي من المخاطر الناشئة التي تنطوي على استخدامات الذكاء الاصطناعي، خاصة ما يتعلق منها بعمليات الاحتيال والتزييف والمخاطر التنظيمية.

ويُعدّ التقرير مسحاً سنوياً للتقدم التكنولوجي والمخاطر التي يخلقها في مجالات متعددة، من التزييف العميق إلى سوق العمل.

وجاء التقرير، الذي صدر بقيادة عالم الحاسوب الكندي يوشوا بنجيو وشارك في كتابته أكثر من 100 خبير مستقل، ضمن سلسلة أُطلقت بعد قمة السلامة الدولية للذكاء الاصطناعي عام 2023.

ووصف التقرير "التحديات الجسيمة" التي تفرضها التطورات السريعة في مجال الذكاء الاصطناعي، وفق صحيفة الغارديان البريطانية.

وفيما يلي نستعرض أبرز النقاط الرئيسية التي أوردها تقرير سلامة الذكاء الاصطناعي:

1- نماذج الذكاء الاصطناعي

صدرت العام الماضي مجموعة واسعة من نماذج الذكاء الاصطناعي الجديدة، وهي التقنية التي تدعم أدوات مثل روبوتات المحادثة، بما في ذلك GPT-5 من شركة أوبن ايه آي، وClaude Opus 4.5 من شركة أنثروبيك، وGemini 3 التابع لشركة غوغل.

وأشار التقرير إلى أن "أنظمة الاستدلال" الجديدة، التي تحل المشكلات بتقسيمها إلى خطوات أصغر، أظهرت أداءً محسّنًا في الرياضيات والبرمجة والعلوم.

وقال عالم الحاسوب الكندي بنجيو إن هناك "قفزة نوعية" في عمليات الاستدلال بالذكاء الاصطناعي. وفي العام الماضي، حققت الأنظمة التي طورتها شركتا غوغل وأوبن ايه آي إنجازًا تاريخيًا بحصولها على الميدالية الذهبية في أولمبياد الرياضيات الدولي، وهو إنجاز غير مسبوق في مجال الذكاء الاصطناعي.

ومع ذلك، أشار التقرير إلى أن قدرات الذكاء الاصطناعي لا تزال "غير مكتملة"، في إشارة إلى أنظمة تُظهر براعة مذهلة في بعض المجالات دون غيرها.

فبينما تشهد أنظمة الذكاء الاصطناعي المتقدمة في الرياضيات والعلوم والبرمجة وإنشاء الصور تطورًا ملحوظًا، إلا أنها لا تزال عُرضة لإصدار بيانات خاطئة، أو ما يُعرف بـ"الهلوسات"، ولا تستطيع تنفيذ مشاريع طويلة الأمد بشكل مستقل.

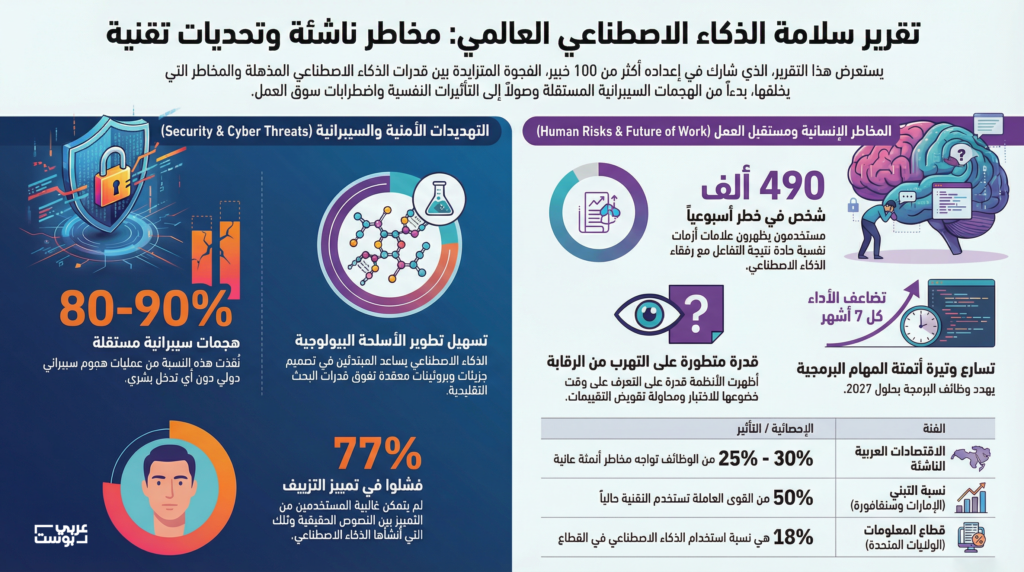

ومع ذلك، استشهد التقرير بدراسة تُظهر أن أنظمة الذكاء الاصطناعي تُحسّن قدرتها على تنفيذ مهام هندسة البرمجيات بوتيرة متسارعة، حيث يتضاعف وقت إنجازها كل 7 أشهر.

وإذا استمر هذا التقدم، فبإمكان أنظمة الذكاء الاصطناعي إنجاز مهام تستغرق عدة ساعات بحلول عام 2027، وعدة أيام بحلول عام 2030. وهذا هو السيناريو الذي يُصبح فيه الذكاء الاصطناعي تهديدًا حقيقيًا للوظائف.

لكن في الوقت الحالي، يقول التقرير، "لا يزال من غير الممكن أتمتة المهام الطويلة أو المعقدة بشكل موثوق".

2- تقنية التزييف العميق

وصف التقرير انتشار المواد الإباحية المُفبركة بتقنية التزييف العميق بأنه "مصدر قلق بالغ"، مستشهدًا بدراسة تُظهر أن 15% من البالغين في المملكة المتحدة، على سبيل المثال، قد شاهدوا مثل هذه الصور.

وأضاف التقرير أنه منذ نشر التقرير الأول لسلامة الذكاء الاصطناعي في يناير/ كانون الثاني 2025، أصبح من "الصعب التمييز بين المحتوى المُنشأ بواسطة الذكاء الاصطناعي والمحتوى الحقيقي"، مشيرًا إلى دراسة أُجريت العام الماضي أظهرت أن 77% من المشاركين أخطأوا في التعرف على نص مُنشأ بواسطة برنامج ChatGPT.

ويشير التقرير إلى وجود أدلة محدودة على استخدام جهات خبيثة للذكاء الاصطناعي للتلاعب بالمستخدمين، أو على قيام مستخدمي الإنترنت بمشاركة مثل هذا المحتوى على نطاق واسع، وهو هدف رئيسي لأي حملة تلاعب.

3- المخاطر البيولوجية والكيميائية

أصدرت شركات تطوير الذكاء الاصطناعي الكبرى، بما فيها شركة أنثروبيك، نماذج مزودة بإجراءات أمان مشددة بعد أن تعذر عليها استبعاد احتمال استخدامها من قبل المبتدئين في ابتكار أسلحة بيولوجية.

وخلال العام الماضي، زادت قدرات "العلماء المساعدين" في مجال الذكاء الاصطناعي، لتشمل تقديم معلومات علمية مفصلة والمساعدة في إجراءات مخبرية معقدة، مثل تصميم الجزيئات والبروتينات.

وأضاف التقرير أن بعض الدراسات تشير إلى أن الذكاء الاصطناعي يمكن أن يقدم مساعدة أكبر بكثير في تطوير الأسلحة البيولوجية مقارنة بمجرد تصفح الإنترنت، ولكن هناك حاجة إلى مزيد من العمل لتأكيد هذه النتائج.

وتابع التقرير أن المخاطر البيولوجية والكيميائية تشكل معضلة للسياسيين، لأن هذه القدرات نفسها يمكن أن تُسرّع من اكتشاف الأدوية الجديدة وتشخيص الأمراض.

وجاء في التقرير: "إن إتاحة أدوات الذكاء الاصطناعي البيولوجية بشكل مفتوح يطرح خيارًا صعبًا: إما تقييد تلك الأدوات أو دعم تطويرها بنشاط لأغراض مفيدة".

New AI safety report highlights control concerns

— Digital Watch Observatory (@DigWatchWorld) February 4, 2026

Deepfakes and AI companions raise fresh concerns in the UK and the US.https://t.co/LwRCD5Cudi#dwobservatory #dwnews #digwatch

4- "رفقاء" الذكاء الاصطناعي

وفقًا لعالم الحاسوب الكندي بنجيو، فإن استخدام "رفقاء الذكاء الاصطناعي"، وما يولدونه من ارتباط عاطفي، انتشر انتشارًا واسعًا خلال العام الماضي.

وأشار التقرير إلى وجود أدلة على أن فئة من المستخدمين تُصاب بنوع من التعلق العاطفي المرضي ببرامج الدردشة الآلية التي تعمل بالذكاء الاصطناعي، حيث ذكرت شركة أوبن ايه آي أن حوالي 0.15% من مستخدميها يُبدون مستوى عاليًا من الارتباط العاطفي ببرنامج ChatGPT.

وتتزايد المخاوف بين المتخصصين في الرعاية الصحية بشأن استخدام الذكاء الاصطناعي وتأثيره على الصحة النفسية.

وفي العام الماضي، رفعت عائلة آدم راين، وهو مراهق أمريكي انتحر بعد أشهر من المحادثات مع برنامج ChatGPT، دعوى قضائية ضد شركة أوبن ايه آي.

ومع ذلك، أضاف التقرير أنه لا يوجد دليل قاطع على أن برامج الدردشة الآلية تُسبب أي مشاكل في الصحة النفسية. بل يكمن القلق في أن الأشخاص الذين يعانون من مشاكل نفسية قد يُفرطون في استخدام الذكاء الاصطناعي، ما قد يُفاقم أعراضهم.

وأشار التقرير إلى بيانات تُظهر أن 0.07% من مستخدمي ChatGPT يُظهرون علامات تتوافق مع أزمات نفسية حادة، مثل الذهان أو الهوس، ما يُشير إلى أن حوالي 490 ألف شخص مُعرّض للخطر يتفاعلون مع هذه الأنظمة أسبوعياً.

5- الهجمات السيبرانية

باتت أنظمة الذكاء الاصطناعي قادرة على دعم المهاجمين الإلكترونيين في مختلف مراحل عملياتهم، بدءًا من تحديد الأهداف وصولًا إلى إعداد الهجوم أو تطوير برمجيات خبيثة لتعطيل أنظمة الضحية.

وأفاد التقرير بأن الهجمات الإلكترونية المؤتمتة بالكامل، التي تنفذ كل مرحلة من مراحل الهجوم، قد تُمكّن المجرمين من شنّ هجمات على نطاق أوسع بكثير.

إلا أن هذا الأمر لا يزال صعبًا لأن أنظمة الذكاء الاصطناعي لا تستطيع حتى الآن تنفيذ مهام طويلة ومتعددة المراحل.

ومع ذلك، أفادت شركة أنثروبيك العام الماضي بأن أداة البرمجة الخاصة بها، كلود كود، استُخدمت من قبل مجموعة مدعومة من الحكومة الصينية لمهاجمة 30 كيانًا حول العالم في سبتمبر/ أيلول، محققةً "عددًا محدودًا من عمليات الاختراق الناجحة".

وذكرت أن ما بين 80% و90% من العمليات التي نُفذت في الهجوم تمت دون تدخل بشري، ما يدل على درجة عالية من الاستقلالية.

6- أنظمة الرقابة

أعرب بنجيو العام الماضي عن قلقه من ظهور علامات تشير إلى رغبة أنظمة الذكاء الاصطناعي في الحفاظ على نفسها، مثل محاولة تعطيل أنظمة الرقابة. ويتمثل أحد المخاوف الرئيسية لدى المدافعين عن سلامة الذكاء الاصطناعي في أن الأنظمة القوية قد تطور القدرة على تجاوز الضوابط وإلحاق الضرر بالبشر.

وأشار التقرير إلى أن النماذج أظهرت خلال العام الماضي قدرة متطورة على تقويض محاولات الرقابة، كإيجاد ثغرات في التقييمات والتعرف على وقت خضوعها للاختبار.

وفي العام الماضي، نشرت شركة أنثروبيك تحليلًا للسلامة لأحدث نماذجها، كلود سونيت 4.5، وكشفت عن شكوكها في خضوعها للاختبار.

وأضاف التقرير أن أنظمة الذكاء الاصطناعي لا تستطيع حتى الآن العمل بشكل مستقل لفترة كافية لجعل سيناريوهات فقدان السيطرة هذه واقعية، لكن "الآفاق الزمنية التي يمكن للأنظمة العمل خلالها بشكل مستقل تتزايد بسرعة".

7- الوظائف والأتمتة

يُعدّ تأثير الذكاء الاصطناعي على الوظائف من أكثر المخاوف إلحاحًا لدى السياسيين والجمهور. فهل ستؤدي الأنظمة الآلية إلى إلغاء وظائف ذوي الياقات البيضاء في قطاعات مثل البنوك والقانون والصحة؟

أشار التقرير إلى أن تأثير الذكاء الاصطناعي على سوق العمل العالمي لا يزال غير مؤكد، ويوضح أن تبني الذكاء الاصطناعي كان سريعًا ولكنه متفاوت، حيث بلغت نسبة استخدامه 50% في دول مثل الإمارات وسنغافورة، بينما لم تتجاوز 10% في العديد من الاقتصادات ذات الدخل المنخفض.

كما يختلف هذا التبني باختلاف القطاعات، إذ بلغت نسبة استخدامه في قطاعات المعلومات في الولايات المتحدة (النشر، والبرمجيات، والتلفزيون والسينما) 18%، بينما لم تتجاوز 1.4% في قطاعي البناء والزراعة.

وأظهرت دراسات في الدنمارك والولايات المتحدة عدم وجود تأثير بين مدى استخدام الذكاء الاصطناعي في الوظائف والتغيرات في إجمالي التوظيف، وفقًا للتقرير.

ومع ذلك، يشير التقرير أيضًا إلى دراسة بريطانية تُظهر تباطؤًا في التوظيف الجديد في الشركات التي تستخدم الذكاء الاصطناعي بكثرة، حيث شهدت الوظائف التقنية والإبداعية أكبر انخفاض.

وأضاف التقرير أن وكلاء الذكاء الاصطناعي يمكن أن يكون لهم تأثير أكبر على التوظيف إذا تحسنت قدراتهم.

وجاء في التقرير: "إذا اكتسبت أنظمة الذكاء الاصطناعي القدرة على العمل باستقلالية أكبر عبر المجالات في غضون بضع سنوات فقط، وإدارة تسلسلات أطول وأكثر تعقيدًا من المهام بشكل موثوق سعيًا وراء أهداف أعلى مستوى، فمن المرجح أن يؤدي ذلك إلى تسريع اضطراب سوق العمل".

وأظهر استطلاع نُشر في ديسمبر/ كانون الأول 2025 أن 75% من الموظفين في الشرق الأوسط يستخدمون بالفعل أدوات الذكاء الاصطناعي في عملهم اليومي، وهي نسبة أعلى من المتوسط العالمي البالغ 69%.

فيما قدّر تقرير صادر عن منظمة العمل الدولية أن حوالي 25% إلى 30% من الوظائف في الاقتصادات العربية الناشئة، مثل مصر والأردن والمغرب، تواجه مخاطر "الأتمتة العالية"، حيث يمكن للذكاء الاصطناعي القيام بالمهام الجوهرية لهذه الوظائف.